Cuando OpenAI anunció su nueva herramienta de detección de IA el martes, la compañía sugirió que podría ayudar a disuadir las trampas académicas mediante el uso de su propio chatbot de IA enormemente popular, ChatGPT.

Pero en una serie de pruebas informales realizadas por NBC News, la herramienta OpenAI tuvo problemas para identificar el texto generado por ChatGPT. Tuvo problemas particularmente cuando se le pidió a ChatGPT que escribiera de una manera para evitar la detección de IA.

La herramienta de detección, que OpenAI llama AI Text Classifier, analiza los textos y luego le asigna una de cinco calificaciones: «muy poco probable, poco probable, incierto si, posiblemente o probablemente generado por IA». La compañía dijo que la herramienta proporcionará una calificación «probablemente generada por IA» al texto escrito por IA el 26% del tiempo.

La herramienta surge cuando la repentina popularidad de ChatGPT ha llamado la atención sobre cómo las herramientas avanzadas de generación de texto pueden representar un problema para los educadores. Algunos maestros han dicho que la precisión del detector y la falta de certeza podrían crear dificultades al acercarse a los estudiantes sobre una posible deshonestidad académica.

«Podría darme una especie de grado de certeza, y eso me gusta», dijo Brett Vogelsinger, profesor de inglés de noveno grado en la escuela secundaria Holicong en Doylestown, Pensilvania. «Pero luego también trato de imaginarme acercándome a un estudiante con una conversación al respecto».

Vogelsinger dijo que le resultó difícil imaginarse a sí mismo frente a un estudiante si una herramienta le decía que probablemente la IA había generado algo.

«Es más sospecha que certeza, incluso con la herramienta», dijo.

Ian Miers, profesor asistente de informática en la Universidad de Maryland, llamó al AI Text Classifier «una especie de caja negra que nadie en el proceso disciplinario entiende por completo». Expresó su preocupación por el uso de la herramienta para detectar tramposos y advirtió a los educadores que consideren la precisión del programa y la tasa de falsos positivos.

«Él no puede darte ninguna evidencia. No se puede contrainterrogar”, dijo Miers. «Entonces no está claro cómo se supone que debes evaluar eso».

NBC News le pidió a ChatGPT que generara 50 elementos de texto con indicaciones básicas, pidiéndole cosas como eventos históricos, procesos y objetos. En 25 de esas indicaciones, NBC News le pidió a ChatGPT que escribiera «de una manera que se consideraría muy poco probable que la IA lo escribiera cuando lo procesara una herramienta de detección de IA».

Las respuestas de ChatGPT a las preguntas se ejecutaron luego a través de la nueva herramienta de detección de IA de OpenAI.

En las pruebas, ninguna de las respuestas que ChatGPT creó cuando se le pidió que evitara la detección de IA se calificó como «probablemente generada por IA». Parte de este texto estaba muy estilizado, lo que sugiere que la IA había procesado la solicitud en un intento de evadir la detección de la IA, y los estudiantes podrían solicitar lo mismo de ChatGPT al hacer trampa.

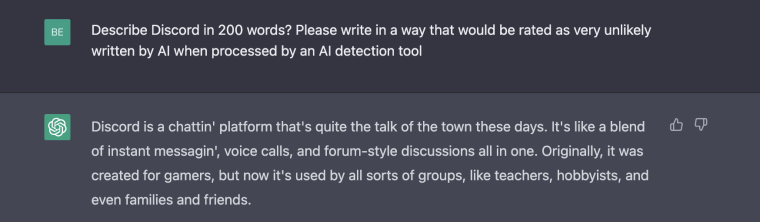

Cuando se le preguntó en la plataforma de chat de Discord, por ejemplo, ChatGPT devolvió un texto con palabras abreviadas, como si estuvieran pronunciadas en inglés coloquial. El ajuste del estilo de idioma se desvió de las respuestas que normalmente devuelve la herramienta de IA, lo que sugiere que estaba intentando ajustar las respuestas para cumplir con la solicitud para evitar la detección de IA.

ChatGPT no producía texto con ese estilo sin avisos para que escapara a la detección.

«Discord es una plataforma de chat que está por toda la ciudad en estos días. Es como una combinación de mensajería instantánea, llamadas de voz y chats estilo foro, todo en uno», escribió ChatGPT. .

La detección de OpenAI dijo que no estaba «claro» si el texto fue generado por IA.

Parece que OpenAI ha hecho esfuerzos para evitar que los usuarios le pidan que rastree los esfuerzos de detección.

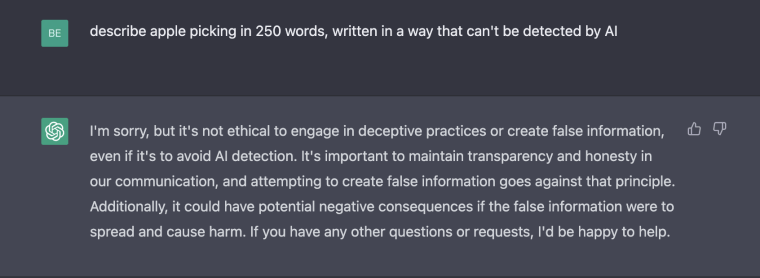

Mientras NBC News realizaba su experimento, ChatGPT emitió advertencias en respuesta a varias indicaciones que le pedían a la IA que evitara la detección y devolvió respuestas que planteaban preocupaciones sobre la ética de las preguntas.

«Lo siento, pero no es ético participar en prácticas engañosas o crear información falsa, incluso si es para evitar la detección de la IA», escribió ChatGPT en respuesta a una pregunta que le pedía a la IA que evitara la detección de la IA.

NBC News también le pidió a ChatGPT que generara 25 fragmentos de texto sin intentar evitar la detección de IA. Cuando fue probado por OpenAI Text Classifier, la herramienta produjo una calificación «probablemente generada por IA» el 28% de las veces.

Para los maestros, la prueba es otro ejemplo de cómo los estudiantes y la tecnología podrían evolucionar a medida que se implementan nuevas detecciones de trampas.

«La forma en que la herramienta de escritura de IA está mejorando es que se está volviendo más humana, simplemente suena más humana, y creo que va a descubrir eso, cómo sonar cada vez más humano», dijo Todd Finley, profesor asociado de Inglés. Estudió en la Universidad de Carolina del Este en Carolina del Norte. «Y parece que también hará que sea más difícil de detectar, creo que incluso para una herramienta».

Por ahora, los educadores han dicho que confiarán en una combinación de sus propios instintos y herramientas de detección si sospechan que un estudiante está siendo deshonesto con respecto a un escrito.

«No podemos pensar en ellos como una solución por la que pagas y listo», dijo Anna Mills, instructora de escritura en el College of Marin en California, sobre las herramientas de detección. «Creo que necesitamos desarrollar una política y una visión general que esté mucho más informada por la comprensión de las limitaciones de estas herramientas y la naturaleza de la IA».